Robot vũ trang tự hành sẽ là "thảm họa vô hạn"

Robot và các vũ khí tự hành đang ngày càng phổ biến trong thế giới hiện đại. Nhưng các nhà khoa học cảnh báo, nếu không kiểm soát tốt, chúng có thể trở thành "thảm họa vô hạn".

Một báo cáo mang tên "Autonomous Weapons and Operational Risk report" (Tạm dịch: Vũ khí tự hành và rủi ro) của Trung tâm An ninh mới - CNA (Mỹ) vừa được công bố đầu tuần này đã làm dấy lên mối lo ngại về khả năng ra quyết định của các hệ thống vũ khí tự hành, bao gồm cả máy bay không người lái.

Vũ khí tự hành, chẳng hạn như máy bay không người lái (hình minh họa) hoặc các hệ thống tên lửa dẫn đường tiên tiến có thể không chỉ đưa ra các quyết định sai lầm mà còn có thể gây ra những nguy hiểm khôn lường nếu bị tin tặc tấn công.

Cựu Bộ trưởng bộ Quốc phòng Hoa Kỳ Paul Scharre, tác giả chính của báo cáo cảnh báo, việc sử dụng các robot vũ trang có thể giảm bớt gánh nặng của con người trong chiến tranh, tuy nhiên, những người chịu trách nhiệm cần phải cảnh giác với việc bị ru ngủ trong một cảm giác bảo mật sai lầm.

Những loại máy móc tự hành - như thiết bị bay không người lái và các hệ thống hoặc tên lửa dẫn đường tiên tiến, không chỉ có thể đưa ra những quyết định sai lầm mà chúng còn có thể được sử dụng để chống lại chúng ta nếu bị tin tặc tấn công.

Các chuyên gia cho biết, nếu mắc phải một trong hai khả năng trên, máy móc tự hành có thể là "thảm họa vô hạn".

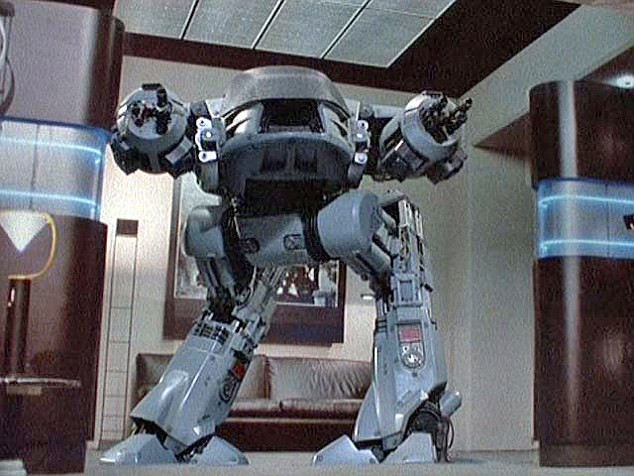

Từ lâu Hollywood đã đưa ra những cảnh báo tương tự trong những bộ phim của mình, có thể lấy ví dụ như bộ phim Robocop được sản xuất vào năm 1987, trong đó một robot an ninh không nhận ra mục tiêu thường dân và tiêu diệt luôn mục tiêu đó.

Hollywood từ lâu đã đưa đề tài này lên phim. Trong Robocop năm 1987, một robot an ninh đã tiêu diệt nhầm mục tiêu thường dân vì không thể nhận dạng chuẩn xác.

Tiến sĩ Sarah Kreps, một chuyên gia máy bay chiến đấu không người lái đến từ trường Đại học Cornel cảnh báo rằng, phát triển vũ khí tự hành sẽ dẫn đến hai vấn đề chính: Đó là việc thiếu tính chủ quan để nhận ra đâu là bạn, đâu là thù và vấn đề tin tặc.

Lý giải về những hạn chế của máy móc thông minh trong việc nhận ra mục tiêu, các chuyên gia bảo mật đã nhấn mạnh sự cần thiết để giữ con người ở trong khuôn khổ. Sự rắc rối vốn có của một vùng chiến sự khiến cho việc chọn lựa mục tiêu rất khó khăn, nhất là nếu có lính bị bắt làm tù binh.

"Bạn không thể đặt những quyết định chủ quan về việc ai là một chiến binh hay là một dân thường vào một thuật toán. Một con người, hay nhiều người phải được phân tích hành vi, để xem họ có trực tiếp và tích cực tham gia chiến đấu hay không", tiến sĩ Kreps nói.

Máy móc không thể nhận định chủ quan giống con người và cũng không thể lập trình để làm được việc đó, vì vậy chúng ta không thể trông cậy chúng nhận ra đâu là bạn là thù.

"Tình trạng của đối phương thường mang màu sắc phán đoán chủ quan và nó không dễ dàng để có thể được lập trình trong một loại vũ khí tự hành. Chúng ta không nên bị ru ngủ khi nghĩ rằng công nghệ có thể làm cho các quyết định dễ dàng hơn".

Ngoài việc thiếu sự xét đoán chủ quan, quyền tự trị mang tới sự đe dọa từ các cuộc tấn công mạng. Nếu các hệ thống an ninh bảo vệ các công nghệ tự hành có thể được ghi đè lên bởi các hacker, nó có thể gây ra sự tàn phá trên chiến trường.

"Nếu một nhóm tin tặc có thể hack vào những khe hở của hệ thống an ninh tại Lầu Năm Góc, họ gần như chắc chắn có thể hack vào hệ thống điều khiển vũ khí tự hành. Và trường hợp này sẽ mang lại thảm họa bất tận", tiến sĩ Kreps chia sẻ.

Báo cáo kết luận rằng, vì lý do an ninh, các nước có khả năng sẽ tiếp cận vũ khí tự trị cần minh bạch và rõ ràng với thế giới trong cách thức thực hiện của mình.

Kỹ thuật mới phát hiện dấu vân tay trên giấy ướt

Các nhà nghiên cứu ở Đại học Hebrew (HU) tại Jerusalem, Israel đã tìm ra một phương pháp mới phát hiện dấu vân tay cả trên giấy ướt, công việc mà công nghệ trước đây khó thực hiện được.

Kenguru – chiếc xe sinh ra cho người khuyết tật, chỉ có một cửa duy nhất nhưng cực tiện cho người đi xe lăn

Hãng Community Cars ở bang Texas (Mỹ) đã sáng chế ra một loại ô tô điện mang tên Kenguru, dành cho người khuyết tật phải ngồi xe lăn.

Robot cứu hộ hình người của NASA

Cơ quan Hàng không Vũ trụ Mỹ (NASA) mới giới thiệu một loại robot mới, có khả năng đứng bằng hai chân như người và được sử dụng để hỗ trợ cho các công việc cứu hộ.

Top 10 mẫu xe lưỡng cư ấn tượng nhất trên thế giới

Xuất hiện đầu tiên vào Chiến tranh Thế giới thứ II, xe lưỡng cư là loại phương tiện vừa hoạt động trên bờ, vừa có thể vận hành dưới nước

Tham vọng chế tạo Iron Man của quân đội Mỹ

Bộ Tư lệnh Lực lượng Đặc biệt của Mỹ (SOCOM) hiện đang theo đuổi một chương trình mang tính cách mạng nhằm hỗ trợ năng lực siêu nhân cho binh sĩ trong nhiệm vụ tác chiến.

Công nghệ tàng hình là gì? Nó hoạt động thế nào?

Bạn đã từng nghe đến máy bay tàng hình, tàu ngầm tàng hình nhưng bạn có biết nghĩa của tàng hình ở đây thực sự là gì?