Ứng dụng AI trong vũ khí tự động - con dao 2 lưỡi

Trong khi vũ khí tự động được sử dụng ngày càng nhiều, các nhà khoa học và người ủng hộ nhân quyền vẫn kêu gọi cần có quy định mạnh mẽ hơn trong việc sử dụng các hệ thống này.

Một quân nhân thuộc Trung đoàn thiết giáp số 1 của Úc đang điều khiển từ xa một hệ thống vũ khí (Ảnh: Lực lượng Quốc phòng Úc).

Thế giới đang chuyển sang sử dụng vũ khí tự động có sử dụng trí tuệ nhân tạo trong các xung đột vũ trang. Trong khi đó, các nhà khoa học và người ủng hộ nhân quyền kêu gọi xây dựng các quy định mạnh mẽ hơn để hướng dẫn sử dụng những hệ thống vũ khí này.

Tháng trước, Lực lượng Quốc phòng Úc công bố một tổ hợp vũ khí mới, trong đó có các máy bay không người lái, xe chiến đấu robot, xe tăng không người lái và chó robot dọn mìn. Đây là những vũ khí bán tự động và vẫn cần được con người tham gia điều khiển một phần.

Trung tá Jakes Penley (trái) và Trung tá Adam Hepworth (phải) ở Căn cứ quân sự Puckapunyal, Úc (Ảnh: ABC Shepparton: Charmaine Manuel).

Giám đốc phụ trách các hệ thống tự động và robot, Trung tá Adam Hepworth, cho biết quân đội Úc nhận thấy có thể sử dụng trí tuệ nhân tạo (AI) trong quân sự, kể cả các nội dung hành chính và chiến đấu, nhưng điều quan trọng là phải duy trì được quyền giám hộ của con người trong việc ra quyết định.

Ông cho biết tất cả các hệ thống quân đội Úc sử dụng đều phải qua được quy trình kiểm tra theo nghĩa vụ trong nước và luật pháp quốc tế.

Tuy nhiên, một số nhà khoa học hàng đầu nói rằng vẫn cần có các khung quy định mạnh mẽ hơn nữa để kiểm soát việc sử dụng các hệ thống quân sự này.

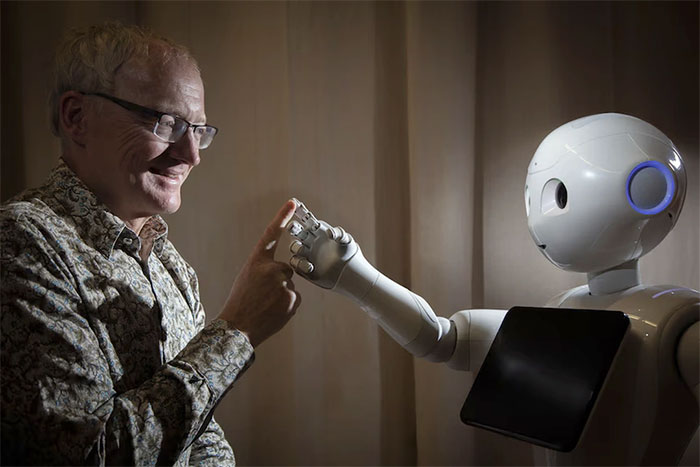

Giáo sư đầu ngành trong lĩnh vực AI Toby Walsh ở Viện AI, Trường đại học New South Wales, Úc, nói rằng trí tuệ nhân tạo là con dao hai lưỡi (Ảnh: TU Berlin/Press/Christian Kielmann).

Theo Giáo sư Toby Walsh ở Viện AI, Trường đại học New South Wales, Úc, việc sử dụng AI và các công cụ tự động là con dao hai lưỡi.

Về mặt tích cực, một số ứng dụng mang lại nhiều lợi ích, ví dụ như robot dọn mìn. "Không nên có thêm bất kỳ người nào phải chịu nguy cơ mất mạng hoặc mất chân, tay do việc dò mìn gây ra." - ông nói - "đây là công việc hoàn toàn phù hợp để sử dụng robot".

Chúng ta có thể sử dụng chó robot làm công việc dọn mìn (Ảnh: ABC Shepparton: Charmaine Manuel).

"Nhưng đi đôi với điều đó, tôi cho rằng cũng có những trường hợp giao phó việc ra quyết định cho các thuật toán sẽ dẫn chúng ta đến những kết cục vô cùng đen tối, vô cùng nguy hiểm" - Giáo sư Walsh nói thêm. Theo ông, phần mềm sử dụng trong các vũ khí rất dễ bị đánh cắp, sao chép hoặc tác động.

Máy móc không biết xác định giá trị của mạng người

Ủy viên Ủy ban Nhân quyền Úc, bà Lorraine Finlay nói rằng việc sử dụng vũ khí tự động dẫn đến những thách thức cho các nguyên tắc mà luật nhân quyền quốc tế đã đặt ra. Bà cho biết hệ thống kiểm soát của Công ước Geneva có những lỗ hổng vì vũ khí tự động không được thiết kế để rút kinh nghiệm từ mỗi một nhiệm vụ và công nghệ thì liên tục phát triển.

Có những quan ngại rằng liệu máy móc có thể thực sự biết cân nhắc hay không, bởi vì chúng không hiểu giá trị của mạng sống con người.

"Chỉ đơn giản nói rằng vẫn có sự tham gia của con người ở đâu đó trong toàn bộ quá trình sử dụng những vũ khí này là chưa đủ, mà cần xác định rõ vị trí của họ trong quá trình đó, quyền hạn của họ đến đâu, họ là người đưa ra quyết định quan trọng hay việc này được giao cho máy móc" - bà Finlay nói.

Máy bay không người lái đang trình diễn ở Puckapunyal (Ảnh: Lực lượng Quốc phòng Úc.)

Không có quy định cụ thể nào về vũ khí tự động sát thương và nhiều ý kiến khoa học cũng như nhân quyền cho rằng cần có những quy định như vậy.

Tháng 11/2023, Úc đã bỏ phiếu tán đồng nghị quyết của Liên hợp quốc về thúc đẩy cộng đồng quốc tế xem xét các thách thức do các hệ thống vũ khí tự động gây ra. "Bây giờ là lúc cần thiết để giải quyết những vấn đề này và đảm bảo rằng các biện pháp bảo vệ được thực hiện ngay lập tức" - bà Finlay nói.

AI đã có thể tái hiện chính xác đến hơn 80% hình ảnh trong não người

Mô hình AI có tên gọi Mind-Vis, được đào tạo trên một tập dữ liệu lớn với hơn 160.000 lần quét não đã có thể tái hiện đến 84% những gì con người suy nghĩ.

Robot tấn công tàn bạo kỹ sư tại nhà máy Tesla, viễn cảnh đáng sợ nhất của tương lai đã xảy ra?

Một kỹ sư làm việc tại nhà máy của Tesla đã bị thương nghiêm trọng sau khi bị một trong những con robot lắp ráp tấn công.

Chỉ với một câu lệnh, AI mới sẽ tạo ra video chân thực như thế này

Từ câu lệnh và mô hình Sora vừa được OpenAI giới thiệu, người dùng sẽ có cho mình một video ngắn dưới một phút, với độ chân thực cao.

Nhà khoa học Trung Quốc tạo ra "đứa trẻ" AI đầu tiên trên thế giới

Nhà khoa học Trung Quốc đã phát triển thành công một "bé gái" là thực thể trí tuệ nhân tạo (AI) ảo đầu tiên trên thế giới.

Top 23 công cụ AI miễn phí, tốt nhất hiện nay bạn có thể chưa biết

Nếu bạn đang tìm kiếm một công cụ AI miễn phí và chất lượng, hãy cùng chúng tôi đến với 23 cái tên được đề cập đến trong bài viết dưới đây.

Máy ảnh AI chụp không cần ống kính

Máy ảnh Paragraphica sử dụng thông tin vị trí, thời tiết, thời gian và AI để tạo ra bức ảnh phức tạp về nơi người dùng đang đứng.