Cảnh báo hình thức dùng AI giả giọng người thân gặp nạn, gọi điện lừa tiền

Do không cẩn thận và tin vào các cuộc gọi hỏi vay tiền từ người thân, 5.000 người đã trở thành nạn nhân của trò lừa đảo mạo danh bằng AI, mất hơn 11 triệu USD.

Trí tuệ nhân tạo (AI) là chủ đề công nghệ được quan tâm nhất hiện nay. Sau màn ra mắt đình đám của ChatGPT, Microsoft và Google là những ông lớn công nghệ theo sau để không bỏ lỡ làn sóng AI với phiên bản Bing tích hợp AI và chatbot Bard hoàn toàn mới.

Mặc dù có tiềm năng rất lớn như trả lời mọi câu hỏi của người dùng, làm thơ, viết code hay tạo lập hình ảnh chỉ từ vài dòng mô tả, các công cụ AI này dần bộc lộ mặt trái đáng báo động. Gần đây, chúng đã bị những nhóm lừa đảo sử dụng để lừa tiền của những người thiếu cảnh giác, ít hiểu biết về công nghệ.

Suýt bị lừa vì tưởng nhầm là cháu trai xin tiền

Cặp vợ chồng già Ruth Card (73 tuổi) và Greg Grace (75 tuổi) đã nhận được một cuộc gọi từ “cháu trai Brandon”, nói rằng anh ta đang ở trong tù nhưng không có ví hay điện thoại. Anh ta cần tiền để hòa giải và thả ra.

Mặc dù là số lạ, giọng nói của người ở đầu dây bên kia rất giống cháu trai nên bà Card đã sốt sắng gửi tiền cho cậu ta. “Tôi rất sợ hãi nên chỉ nghĩ được rằng phải giúp cháu mình ngay lập tức”, bà cụ kể lại.

Cặp vợ chồng già đã rút 3.000 CAD (2.207 USD), là hạn mức rút tiền của tài khoản ngân hàng của họ, sau đó lại đến chi nhánh tiếp theo để rút thêm tiền.

Nhưng tại đây, một quản lý ngân hàng đã gọi họ vào văn phòng nói rằng ngân hàng đã nhận được cuộc gọi tương tự và phát hiện đây chỉ là kẻ lừa đảo, giả mạo giọng nói cháu trai của họ. Lúc này, bà Card và ông Grace mới nhận ra người ở đầu dây bên kia không phải cháu trai mình.

Mọi người cần cảnh giác với các cuộc gọi mượn tiền từ người thân, bạn bè. (Ảnh: Wric).

“Lúc đó, chúng tôi mới tỉnh ra. Chúng tôi đã tin nhầm kẻ đó là cháu trai Brandon nhà mình”, bà Card nói.

Theo Washington Post, với số lượng các chiêu trò mạo danh ngày càng tăng, trường hợp mà bà Card gặp phải đã dấy lên một hình thức lừa tiền tinh vi hơn hẳn. Năm 2022, mạo danh để lừa đảo là chiêu trò phổ biến nhất ở Mỹ với hơn 36.000 vụ việc được báo cáo.

Phần lớn các nhóm lừa đảo giả làm bạn bè, gia đình của nạn nhân. Trong đó, 5.100 vụ lừa đảo diễn dưới hình thức gọi điện thoại, gây thất thoát 11 triệu USD, theo thống kê của Ủy ban Thương mại Liên bang Mỹ (FTC).

Công nghệ phát triển đã khiến các nhóm người xấu dễ dàng bắt chước giọng nói, mạo danh là người thân đang gặp khó khăn mà nạn nhân thường là những người lớn tuổi. Với sự hỗ trợ từ AI, hàng loạt công cụ trực tuyến nay đã có khả năng bắt chước giọng nói một người chỉ từ một tệp âm thanh bình thường, thậm chí là có thể nói bất kỳ nội dung nào người dùng nhập vào.

Các chuyên gia cho biết chính quyền và các cơ quan chức năng vẫn còn lạc hậu, chưa thể cập nhật hình thức lừa đảo tinh vi này. Do đó, phần lớn nạn nhân không thể nhận ra mình đang bị lừa, trong khi các cảnh sát cũng khó lòng truy vết cuộc gọi hay giao dịch chuyển tiền vì nhóm tội phạm này nằm rải rác khắp nơi trên thế giới.

Cách AI đang tiếp tay cho tội phạm

Hình thức mà những kẻ xấu này thường sử dụng nhất là mạo danh người thân thường là con cái, người yêu hay bạn bè của nạn nhân và nài nỉ họ gửi tiền bằng cách nói mình đang gặp cảnh túng quẫn.

Những giọng nói tạo lập bởi AI càng tăng tính chuyên nghiệp và nguy hiểm của chiêu trò này. Đây chính là mặt tối của các AI tạo sinh khi chúng có thể tạo văn bản, hình ảnh hay âm thanh dựa trên bộ dữ liệu được cung cấp trước.

Các phần mềm tạo giọng nói hoạt động bằng cách phân tích những đặc trưng trong giọng nói của một người như độ tuổi, giới tính, ngữ điệu, sau đó tìm kiếm trong kho dữ liệu khổng lồ một giọng nói tương tự và dự đoán các mẫu hội thoại cần tạo ra.

Do đó, chúng có thể tái tạo cao độ, âm sắc của một người và tạo ra một giọng nói hoàn chỉnh y hệt bản gốc. Kho dữ liệu này thường là những đoạn âm thanh từ YouTube, TikTok, Instagram, Facebook hay các podcast, video quảng cáo…

“Hai năm trước, bạn cần rất nhiều tệp âm thanh để bắt chước giọng nói một người. Nhưng giờ đây, chỉ cần bạn từng xuất hiện trên Facebook hoặc TikTok, bất cứ ai cũng có thể giả giọng bạn bằng AI”, Giáo sư Hany Farid tại Đại học California nói.

Ai cũng có thể bị AI bắt chước giọng nói. (Ảnh: Security Intelligence).

EvenLabs là một trong những phần mềm giả lập giọng nói bằng AI nổi tiếng với các gói dịch vụ từ miễn phí đến 5 USD hay 330 USD/tháng. Phần mềm này đã nhận không ít chỉ trích vì bị lạm dụng để “nhét chữ vào miệng” người nổi tiếng, ghép vào các video khiến họ phát ngôn bậy bạ như thật.

Trong một bài đăng Twitter, EvenLabs khẳng định thực hiện các biện pháp bảo mật để giảm thiểu tình trạng lạm dụng cho mục đích xấu như cấm người dùng miễn phí tùy chỉnh giọng nói, ra mắt công cụ phát hiện giọng giả từ AI…

Mất trắng 15.000 USD vì nhẹ dạ

Tuy nhiên, những biện pháp trên vẫn chưa đủ. Benjamin Perkin là một nạn nhân của phần mềm này khi bố mẹ của anh đã mất hàng nghìn USD vì lừa đảo bằng giọng nói. Ác mộng của họ bắt nguồn từ một hôm bố mẹ Perkin nhận một cuộc gọi từ kẻ tự xưng là luật sư.

Người này nói con trai họ đã gây ra tai nạn xe và khiến một người tử vong. Hiện, anh ta đang ngồi trong tù và cần tiền cho các thủ tục pháp lý.

Luật sư này sau đó đã chuyển máy cho Benjamin Perkin, nói rằng anh ta rất cần tiền. Vài tiếng sau, vị luật sư giả mạo lại gọi bố mẹ Perkin một lần nữa và đòi 21.000 CAD (15.449 USD) trước khi lên tòa.

Mặc dù cảm thấy có điều bất thường, hai vợ chồng vẫn không khỏi lo lắng và cứ nghĩ rằng con trai mình đang gặp nguy. “Giọng nói đó giống thật đến mức bố mẹ tôi tin rằng họ đang thật sự nói chuyện với tôi”, Perkin nói. Vì thế, bố mẹ cậu đã đến nhiều ngân hàng khác nhau để lấy tiền và gửi cho vị luật sư này qua cổng chuyển tiền Bitcoin.

Đến khi “Perkin thật” gọi điện, cặp vợ chồng mới vỡ lẽ ra mình đã bị lừa. Sau đó, gia đình anh đã nhanh chóng báo cảnh sát nhưng vẫn không thể lấy lại số tiền. “Toàn bộ số tiền đã không cánh mà bay. Không bảo hiểm. Không cách nào lấy lại. Chúng tôi đã mất trắng rồi”, Perkin nói.

Theo Will Maxson, Phó giám đốc mảng chiêu thức tiếp thị tại Ủy ban Thương mại Liên bang (FTC), việc truy vết những tội phạm lừa đảo bằng giọng nói rất khó vì họ có thể làm giả định vị điện thoại ở bất cứ đâu. Do đó, ông khuyến cáo mọi người nên cẩn thận và cảnh giác hơn.

Nếu người thân bảo họ cần tiền, đừng làm theo lời họ nói ngay lập tức mà gọi đến những thành viên khác trong gia đình để xác nhận. Dù cuộc gọi đến từ số người thân trong nhà, đó vẫn có thể là chiêu trò lừa đảo. Mọi người cũng không nên gửi tiền bằng các thẻ quà hay hình thức khác vì rất khó truy vết, đồng thời cảnh giác với mọi yêu cầu gửi bằng tiền mặt, ông Maxson nói.

Các nhân vật lịch sử sẽ trông như thế nào trong thời hiện đại khi dựng lại với công nghệ AI?

Những vị vua chúa, người nổi tiếng từ hàng trăm, hàng ngàn năm trước hiện ra sống động hơn hẳn sau "cú chạm" của công nghệ.

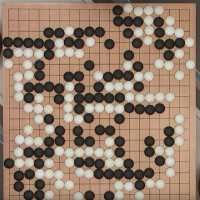

"Trí tuệ nhân tạo" AlphaGo là gì mà khiến con người thán phục?

AlphaGo là gì? Tại sao AlphaGo lại được nhiều người quan tâm như vậy? Điều gì đã khiến cho bộ máy nhân tạo AlphaGo chiến thắng một kiện tướng cờ vây nhiều năm kinh nghiệm?

Tìm hiểu về robot Sophia

Sophia là một robot hình dạng giống con người được phát triển bởi công ty Hanson Robotics ở Hồng Kông.

Công nghệ AI giúp dựng lại chân dung gần như tạc chỉ từ giọng nói

Các nhà khoa học tại Học viện Công nghệ Massachusetts (MIT-Mỹ) lần đầu tiên thành công trong việc ứng dụng thuật toán để tái tạo lại chân dung chỉ từ giọng nói.

Thần thoại Hy Lạp dạy chúng ta điều gì về sự nguy hiểm của AI?

Tin được không khi văn học cổ đại hóa ra có thể cung cấp cho con người hiện đại những hiểu biết có giá trị về trí tuệ nhân tạo.

Trí tuệ nhân tạo là gì? AI (artificial intelligence) là gì?

Định nghĩa trí tuệ nhân tạo: (AI: Artificial Intelligence) có thể được định nghĩa như một ngành của khoa học máy tính liên quan đến việc tự động hóa các hành vi thông minh.